En el ámbito del modelado estadístico y el aprendizaje automático, la selección de modelos es un paso crucial para determinar cuál ofrece el mejor equilibrio entre ajuste y complejidad. Para ello, se utilizan diversas técnicas, entre las que destacan las pruebas estadísticas y los criterios de información, como el AIC (Criterio de Información de Akaike) y el BIC (Criterio de Información Bayesiano).

Pruebas Estadísticas: t-test

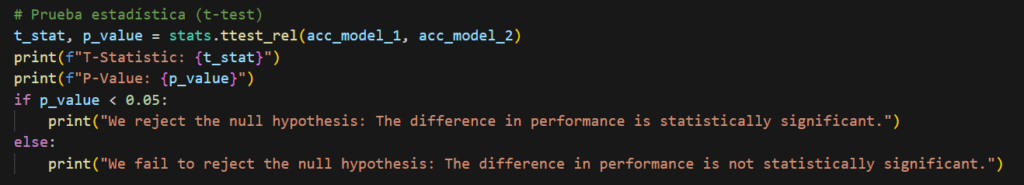

Una de las formas más directas de comparar modelos es a través de pruebas estadísticas, como la prueba t de Student (t-test). Esta prueba se emplea para evaluar si la diferencia entre los errores de dos modelos es estadísticamente significativa. En el contexto de evaluación de modelos, se puede realizar una prueba t para comparar el error medio de los modelos en muestras de validación cruzada. Si la diferencia en los errores medios es significativa, se puede inferir que un modelo es superior al otro con cierto nivel de confianza.

El resultado incluye un valor p (p-value), que indica la probabilidad de observar una diferencia tan grande o mayor si no hubiera una diferencia real entre los modelos.

- Si el p-value < 0.05, se rechaza la hipótesis nula, lo que sugiere que la diferencia en el rendimiento es estadísticamente significativa.

- Si el p-value ≥ 0.05, no se puede rechazar la hipótesis nula, lo que indica que la diferencia podría deberse al azar.

Criterios de Información: AIC y BIC

Los criterios de información como el AIC y el BIC son herramientas que permiten comparar modelos penalizando su complejidad.

- AIC (Criterio de Información de Akaike): Se basa en la verosimilitud del modelo y penaliza la cantidad de parámetros. Un menor valor de AIC indica un mejor equilibrio entre ajuste y complejidad, favoreciendo modelos más parsimoniosos sin sobreajustar los datos.

- BIC (Criterio de Información Bayesiano): Similar al AIC, pero con una penalización más fuerte para modelos con muchos parámetros. Debido a esta penalización adicional, el BIC suele favorecer modelos más simples en comparación con el AIC, especialmente cuando el número de observaciones es grande.

Log-verosimilitud: Se obtiene a partir del logaritmo negativo de la media de acc_model_1 y acc_model_2

Parámetros del modelo: Se asume un valor de 1 para ambos (k_model_1 y k_model_2)

Cálculo de AIC: AIC = 2k − 2 log(L)

Cálculo de BIC: BIC = log(n) k − 2 log(L)

Aplicación y Elección del Modelo

La selección del mejor modelo depende del contexto y del objetivo del análisis. Si el interés está en encontrar un modelo con buen ajuste sin sobreajustar, el AIC puede ser más útil. Si se prefiere un modelo más conservador, el BIC puede ser la mejor opción. Por otro lado, las pruebas estadísticas, como el t-test, pueden servir para confirmar que la mejora observada entre modelos no es producto del azar.

En conclusión, la combinación de pruebas estadísticas y criterios de información permite una evaluación más completa de los modelos, equilibrando precisión y simplicidad para obtener resultados óptimos en análisis estadísticos y aprendizaje automático.