En nuestra entrada anterior hablamos de las Redes Neuronales Recurrentes (RNNs), las cuales eran capaces de recordar información a través del tiempo gracias a un estado oculto. Sin embargo, también vimos que entrenarlas tiene algunas complicaciones como el problema del gradiente evanescente o explosivo.

Para superar estos retos, los investigadores desarrollaron arquitecturas más avanzadas, y una de las más populares actualmente es la GRU (Gated Recurrent Units), propuesta en 2014 por Kyunghyun Cho y su equipo. En este artículo, profundizaremos en qué son exactamente estas GRU, cómo funcionan sus compuertas y por qué han ganado tanta popularidad en los últimos años.

¿Qué hace especial a las GRU?

Las GRU buscan simplificar la complejidad de las redes LSTM (Long Short-Term Memory), otro tipo de red recurrente que ya mencionamos anteriormente. Lo que hace especial a las GRU es que utilizan menos parámetros gracias a la reducción en el número de compuertas, lo que implica menos recursos computacionales y tiempos de entrenamiento más cortos.

Las compuertas de las GRU: Entendiendo cómo funcionan

Las GRU utilizan dos compuertas principales para manejar la memoria dentro de la red:

1. Puerta de actualización (Update gate)

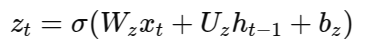

Esta puerta decide cuánta información de los estados anteriores conservar y cuánta información nueva incorporar en el estado actual. Matemáticamente, se expresa así:

- zt es la puerta de actualización

- Wz y Uz son matrices de pesos

- xt es la entrada actual

- ht-1 es el estado oculto anterior

Puerta de reinicio (Reset gate)

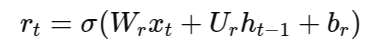

Esta compuerta determina qué información del pasado olvidar, lo cual es especialmente útil cuando el contexto cambia drásticamente dentro de una secuencia. Se define mediante la siguiente fórmula:

- R1 es la puerta de reinicio

- Wr y Ur son matrices de pesos

Cálculo del estado oculto

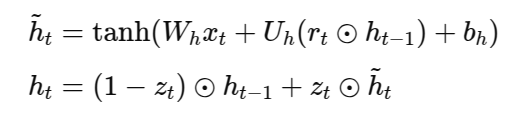

Con esas dos compuertas definidas podemos definir el estado oculto de una GRU como:

Esta es la forma en la que GRU combina de forma eficiente la información almacenada en el estado oculto con la actual.

Las GRU presentan varias ventajas:

Ventajas y aplicaciones de las GRU

- Menos parámetros, lo que facilita el entrenamiento y reduce el sobreajuste.

- Mejor rendimiento en aplicaciones que no requieren una memoria excesivamente profunda.

- Mayor eficiencia computacional comparada con otras arquitecturas complejas como las LSTM.

Son ideales para aplicaciones como:

- Traducción automática de idiomas.

- Reconocimiento de voz.

- Predicción en series temporales.

- Generación de texto coherente y natural.