Autor: Jesús Palomino Abreu

-

Gym Pybullet Drones

En los últimos años han aparecido múltiples librerías para simular robots en 3D, pero pocas se centran específicamente en drones ligeros y, al mismo tiempo, ofrecen una interfaz limpia para control y aprendizaje por refuerzo. gym-pybullet-drones es una de las que mejor resuelve ese problema. Se trata de un entorno construido sobre PyBullet, orientado a…

-

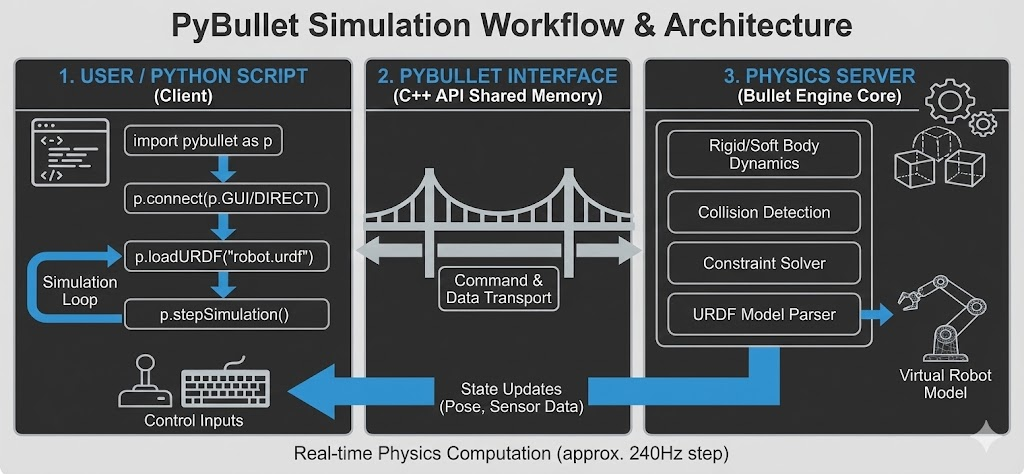

PyBullet

PyBullet es un motor de simulación física en Python diseñado para trabajar con entornos 3D, robótica, dinámica de cuerpos rígidos y control. Su objetivo es ofrecer una herramienta accesible para investigadores, ingenieros y desarrolladores que necesitan un entorno reproducible donde probar algoritmos antes de pasarlos al mundo real. Aunque es ligero y fácil de usar,…

-

Modelando dependencias complejas con Cópulas

En entradas anteriores ya mostramos cómo los Modelos de Mezclas Gaussianas (GMM) pueden reproducir con éxito el comportamiento de motores de helicóptero, mejorando la detección de anomalías incluso con pocos datos. Sin embargo, los GMM no son la única forma de abordar el problema. En esta línea, decidimos explorar otra técnica más general y flexible…

-

Generando datos sintéticos realistas con Modelos de Mezclas Gaussianas (GMM)

Uno de los mayores retos en el mantenimiento predictivo del sector aeroespacial es la falta de datos representativos, especialmente de fallos reales (como ya hemos visto en entradas anteriores). En motores de helicópteros o aeronaves, los sistemas de control y supervisión recogen miles de variables en tiempo real, pero casi todos esos registros pertenecen a…

-

Escasez de Datos de Fallos en el Sector Aeroespacial

En el sector aeroespacial una de las problemáticas más importantes es la seguridad. Es por ello por lo que, entre otras cosas, la aviación se ha convertido en el medio de transporte más seguro del mundo. Esta seguridad es el resultado de un proceso de mejora continua y de mucho trabajo a nivel de ingeniería…

-

Kubeflow y su potencial en entornos de gemelo digital

Los gemelos digitales han dejado de ser un concepto futurista para convertirse en una herramienta cada vez más habitual en sectores como la industria, la energía o el transporte. Su propósito es claro: replicar digitalmente el comportamiento de un sistema físico, integrando datos en tiempo real, modelos predictivos y simulaciones para ofrecer una representación virtual…

-

Usar Next.js para construir interfaces gráficas conectadas a Argo Workflows

Cuando pensamos en construir una interfaz para diseñar y lanzar flujos de trabajo —especialmente si esos flujos acaban ejecutándose en un sistema como Argo Workflows—, necesitamos algo más que una buena librería de frontend: necesitamos una plataforma que nos permita integrar lógica del lado del servidor, gestionar peticiones a APIs, renderizar vistas dinámicas y mantener…

-

UI para la creación de workflows

Como ya hemos comentado en la entrada anterior, Argo Workflows se ha consolidado como una herramienta robusta y altamente configurable para la orquestación de pipelines sobre Kubernetes. Su enfoque declarativo y su integración nativa con contenedores lo convierten en una pieza clave para arquitecturas modernas de datos, ML y CI/CD. Pero estos workflows se crean…

-

Argo Workflows

En el mundo real, los proyectos de datos rara vez se componen de una única ejecución lineal de código. En cambio, suelen implicar múltiples pasos interdependientes: descarga de datos, preprocesamiento, validaciones, entrenamiento de modelos, pruebas, despliegues, generación de informes… Todo esto en diferentes entornos, con distintas configuraciones, y muchas veces ejecutado de forma periódica o…

-

Introducción a Prefect

Si trabajas en ciencia de datos, probablemente esta historia te suene familiar: empiezas en un notebook, explorando y limpiando datos. Luego, ese notebook se convierte en un script de Python. Pronto, tienes varios scripts: uno para preprocesar los datos, otro para entrenar el modelo, un tercero para generar resultados… y te encuentras con que tienes…