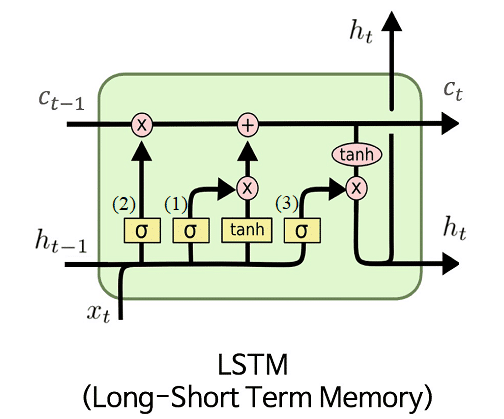

Ya hemos hablado en nuestras entradas anteriores sobre cómo las Redes Neuronales Recurrentes (RNNs) pueden procesar secuencias y mantener información a través del tiempo. También vimos cómo las GRU simplificaron este proceso con menos parámetros. Hoy profundizaremos en otra arquitectura fundamental: las LSTM (Long Short-Term Memory).

Las redes LSTM fueron propuestas en 1997 por Hochreiter y Schmidhuber para resolver específicamente el problema de retener información durante largos períodos de tiempo, algo que las RNNs «vanilla» no lograban con éxito debido al problema del gradiente evanescente.

¿Por qué LSTM?

La principal ventaja de las LSTM es que pueden recordar información a largo plazo. Para lograr esto, utilizan un sistema de compuertas más complejo y completo que las GRU.

Compuertas en una LSTM

La arquitectra de una LSTM se basa en tres compuertas principales, cada uno con un diferente propósito:

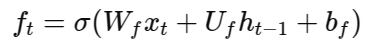

Puerta de olvido (Forget gate)

Esta compuerta decide qué parte de la información pasada debe eliminarse del estado de memoria interno. Es similar a «limpiar» la memoria de detalles poco relevantes:

Conceptualmente, esta puerta funciona preguntándose: «¿Esta información sigue siendo útil?» Si la respuesta es no, la puerta lo olvidará.

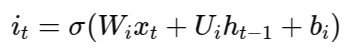

Puerta de entrada (Input gate)

La puerta de entrada decide qué nueva información almacenar en la memoria actual y cuánta de esta información es relevante para el futuro:

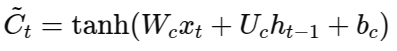

Aquí, la puerta de entrada determina qué información nueva vale la pena recordar, mientras que Ct representa el candidato a ser la nueva memoria.

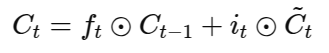

Actualización de la memoria

Después de decidir qué olvidar y qué recordar, se actualiza la memoria interna

Es decir, la LSTM combina la memoria pasada (lo que queda después de olvidar lo innecesario) con la nueva información relevante seleccionada por la puerta de entrada.

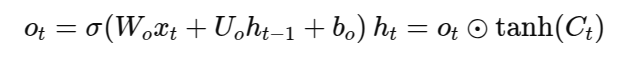

Puerta de salida

Finalmente, la puerta de salida decide cuál es la parte más útil de la memoria interna para enviar al siguiente estado oculto y, eventualmente, para producir una salida visible:

Esta puerta responde a la pregunta: «De todo lo que recuerdo ahora, ¿qué información debería mostrar afuera?»

¿Qué hace especial a las LSTM?

La clave del éxito de las LSTM radica en su capacidad para gestionar selectivamente la memoria de forma eficiente. Esto las convierte en una herramienta ideal para situaciones donde el contexto a largo plazo es importante.

¿LSTM o GRU?

Si bien las GRU son más simples y requieren menos recursos, en casos de uso donde las relaciones entre los datos son más complejas, y por lo tanto se requiere de una arquitectura más compleja y capaz de manejar mejor esas dependencias a largo plazo.